Командой реализованы сотни парсеров сайтов. Для защиты от спамеров онлайн-ресурсы ограничивают или осложняют доступ на считывание данных: лимитируют количество запросов за период, отслеживают IP-адреса, выдают сложную разметку и регулярно изменяют структуру сайта. Разработчики парсеров в ответ используют прокси-серверы, эвристические и адаптирующиеся алгоритмы. Проекты разработки парсеров проводятся на базе повременной оплаты.

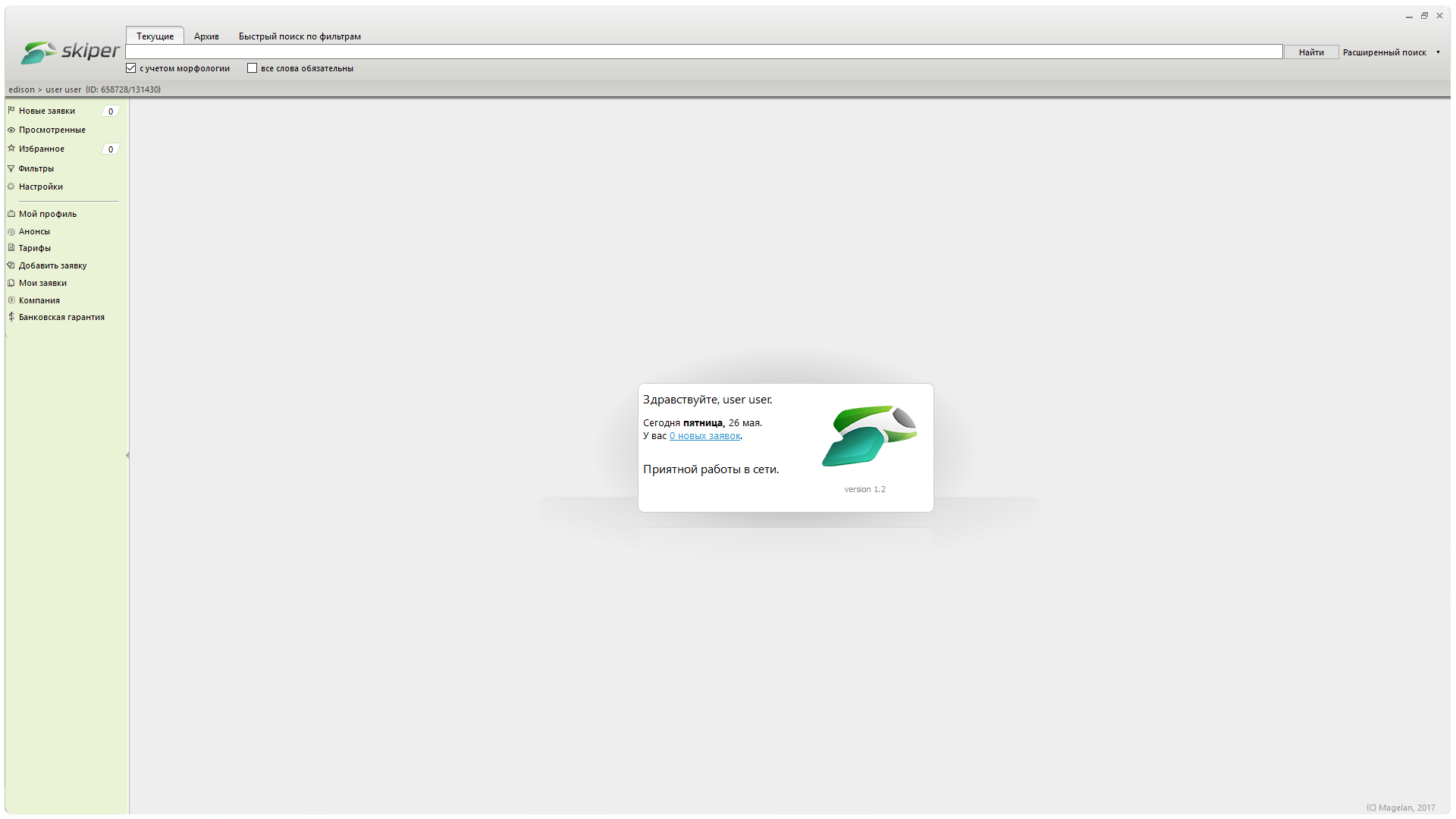

Тендерные и информационные агрегаторы

14 мая 2015

2002–2025

2002–2025